In einem neuen Support-Dokument hat Apple angekündigt, zukünftig in drei verschiedenen Bereichen mehr für die Sicherheit von Kindern zu tun. „Wir möchten dazu beitragen, Kinder vor Verfolgern zu schützen, die Kommunikationsmittel nutzen, um sie anzuwerben und auszubeuten, und die Verbreitung von Material über sexuellen Kindesmissbrauch einzudämmen“, so Apple im Dokument. Die Features sollen zum Start in den USA ausgerollt und dann auch auf weitere Regionen ausgeweitet werden.

Sicherheit bei der Kommunikation

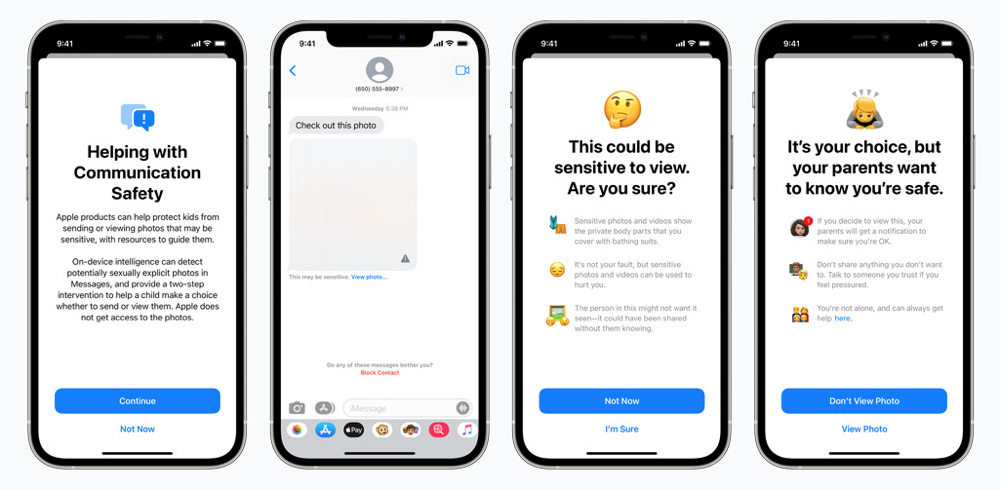

Als erstes wird die iMessage-App auf iPhones, iPads und Macs eine neue Kommunikations-Sicherheits-Funktion erhalten, um Kinder und ihre Eltern zu warnen, wenn sie sexuell eindeutige Fotos erhalten oder versenden. Apple will für diese Zwecke Machine Learning verwenden, um Bildanhänge zu analysieren. Ist sexuell anstößiges Material dabei, wird das Foto automatisch unscharf dargestellt und das Kind gewarnt. Auch beim Versand von sensiblem Bildmaterial sollen Warnungen ausgegeben werden, dass das Foto möglicherweise private Körperteile enthält und verletzend sein könnte. Eltern können bei jungen Kindern auch Benachrichtigungen erhalten, wenn sich das Kind das Bild weiter ansieht oder es weiterverbreitet.

Das Sicherheits-Feature in iMessage soll mit den Updates für iOS 15, iPadOS 15 und macOS Monterey ausgerollt werden und steht dann Familienkonten zur Verfügung, die in der iCloud eingerichtet sind. iMessage-Konversationen sollen weiter per Ende-zu-Ende-Verschlüsselung geschützt bleiben, so dass die privaten Gespräche nicht von Apple gelesen werden können.

Scannen von Fotos auf Material über sexuellen Kindesmissbrauch

Mit iOS 15 und iPadOS 15 wird zudem eine Funktion eingeführt, bekannte Bilder von sexuellem Kindesmissbrauch (Child Sexual Abuse Material, CSAM), die in iCloud Photos gespeichert sind, zu erkennen. In den USA will Apple diese Fälle an das National Center for Missing and Exploited Children (NCMEC), eine gemeinnützige Organisation, die mit den amerikanischen Strafverfolgungsbehörden zusammenarbeitet, melden. Apple berichtet im Support-Dokument:

„Apples Methode zur Erkennung bekannter CSAM ist auf den Schutz der Privatsphäre der Nutzer ausgerichtet. Anstatt Bilder in der Cloud zu scannen, führt das System einen Abgleich auf dem Gerät durch und verwendet dabei eine Datenbank mit bekannten CSAM-Bild-Hashes, die vom NCMEC und anderen Kinderschutzorganisationen bereitgestellt werden. Apple wandelt diese Datenbank in einen unlesbaren Satz von Hashes um, der sicher auf den Geräten der Benutzer gespeichert wird.“

Erweiterte Hinweise in Siri und der Suche

Apple erweitert auch die Hilfestellungen in Siri und Search, indem es zusätzliche Ressourcen bereitstellt, die Kindern und Eltern helfen, online sicher zu bleiben und in unsicheren Situationen Hilfe zu erhalten. So werden Nutzer, die Siri fragen, wie sie Material über sexuellen Kindesmissbrauch oder die Ausbeutung von Kindern melden können, auf Ressourcen verwiesen, wo und wie sie eine Meldung machen können.

Siri und die Suchfunktion werden ebenfalls aktualisiert, um einzugreifen, wenn Nutzer Suchanfragen zu diesem Thema stellen. Diese Eingriffe erklären den Nutzern, dass das Interesse an diesem Thema schädlich und problematisch ist, und stellen Ressourcen von Partnern zur Verfügung, um Hilfe bei diesem Problem zu erhalten. Diese Aktualisierungen für Siri und die Suche werden im Laufe dieses Jahres mit einem Update für iOS 15, iPadOS 15, watchOS 8 und macOS Monterey veröffentlicht.

Dann 👋🏻

Überwachung geht immer schief….

Es geht um Sicherheit! Deswegen gibt es nur eine Fotobibliothek.

Genau mit diesem Argument werden die Konsumenten ruhig gestellt. Das kann man auch anders sehen:

Totalüberwachung durch die Hintertür – Apples fataler Sündenfall | heise online

https://heise.de/-6157251

Und wir bezahlen auch noch um das nutzen zu dürfen 😂

Und in ein paar Jahren wird automatisch die Polizei kontaktiert wenn illegale Bilder in die Photobibliotek gefunden werden. 🤗

So zieht man politische Gegner aus dem Verkehr. 👀

🤣🤣🤣

Heute lachst Du noch, in ein paar Jahren womöglich nicht mehr. Vielleicht wähnst Du dich heute auf der richtigen Seite und morgen kommt es ganz anders.

@midadi

Dir wird das lachen schon noch vergehen.

Es dauert nicht mehr lange, dann musst du dir jedes Wort überlegen, das du auf irgendeinem Textfeld eingibst, um nicht in Schwierigkeiten zu gelangen.

Ihr beide seid witzig mit eurer Ansicht. Wäre auch langweilig ohne „Querdenker“. 😎

Unfassbar, dass die das sogar direkt auf dem Gerät machen. Damit ist alles möglich, sie können jeden auf jede Art und Weise über Fotos ausspionieren.

Mich würde ja mal interessieren, ob die Weisheitsverteiler hier, sich auch schon vor Jahren vom Zuckerberg Imperium, dem Alphabet Clan und natürlich von allen Bonuskarten verabschiedet haben…..

True Words!

Außerdem kapiert wohl kaum einer was der Unterschied zwischen dem Abgleich von Hashwerten bekannter Kinderpornofotos und dem „Durchsuchen des iPhones! ist…

Da wird nur der „Fingerabdruck deiner Fotos mit dem Fingerabdruck schon bekannter Kinderpornos verglichen, auf deinem Gerät… Also wer nicht gerade solch Zeugs gespeichert hat dem kanns egal sein.

PS: Virenscanner arbeiten exakt genau so! Die durchsuchen auch deinen Computer…

Das Problem ist der Einsatz dieser Technologie.

Heute wird sie gegen KiPo eingesetzt (was prinzipiell gut ist, auch wenn ich der Meinung bin das man andere Ansätze verfolgen sollte)… Morgen wird wird das iPhone nach Hashes durchsucht die Staatskritisch oder ähnlich sind.

MaLo: Genau so ist es und genau das verstehen Kandidaten wie beispielsweise auch hier im Forum zu sehen einfach nicht, weil sie nur von 12 bis Mittag denken und außerdem die Geschichte völlig ignorieren. Denn man braucht nur in die Vergangenheit zu schauen, die Geschichte hält etliche Beispiele parat, wo genau so etwas passiert ist. Aber das ist ja länger als 14 Tage her und bei Instagram kann man nichts darüber finden, also ist es quasi nie passiert. 😕

Und welche Rolle spielt das hier? Tatsache ist, dass das hier fragwürdig ist. Ist doch vollkommen egal, was früher wo anders war.

@fussel: Wenn dir das technisch zu hoch ist, ist das verständlich. Tatsächlich kommt es aber auf die Umsetzung an und es ist eben NICHT egal. Komplexität wird durch ignorieren nicht weniger komplex. Ob das wirklich „Tatsache“ ist, entscheidet sich erst noch. Das überlässt du am besten denjenigen, die sich nicht vorschnell ein Urteil bilden und die nicht vorschnell die Augen verschließen, sobald sie (einfache) technische Zusammenhänge nicht verstehen.

Ja.

Apple durchlöchert gerade sein Privatsphäre-Versprechen indem es zum schnüffeln eine Backdoor in sein System baut: https://thenextweb.com/news/apple-csam-scanning-experts-concerns-analysi/amp Wenn die Technik vorhanden ist, kann man damit ALLES abgreifen. Und ausgerechnet die Krake Whatsapp lässt schon verlauten, dass sie nicht scannen wird. Apple Geräte sind für mich gerade ein gutes Stück unattraktiver geworden. Und iCloud Photos habe ich schon ausgeschaltet.

57 Wörter die Du dir hättest sparen können wenn Du den letzten Kommentar in diesem Thread gelesen hättest! Da wird nichts „abgegriffen“ , es findet lediglich ein on Device Hashabgleich statt. Und wenn der Abgleich ein positiv Ergebnis liefert bekommt Apple lediglich einen Hinweis darüber. Niemand sieht deine Fotos…

Wie oben schon geschrieben, jeder Virenscanner arbeitet genau so. Da vertraust Du auch dem Anbieter daß er nur nach Viren sucht!

Bitte erst informieren und dann (evtl.) empören!

Zitat „Once a certain number of photos are detected, the photos in question will be sent to human reviewers within Apple, who determine that the photos are in fact part of the CSAM database.“ Nachzulesen hier: https://www.eff.org/deeplinks/2021/08/apples-plan-think-different-about-encryption-opens-backdoor-your-private-life. Auch eine Einladung an Sie, Lex, sich zu informieren. Die Bilder werden abgegriffen und ein Apple Mitarbeiter (hoffentlich kein Pädo!) schaut sie sich an.

Dann muss das aber auch andere Apps scannen können, wie diese Foto-Tresore und so.

Elternteil 1 zu Elternteil 2: „Guck mal unser Kind hat so einen seltsamen Ausschlag im Schritt, weißt du was ist.“ E2 zu E1: „Hmm, schick mal ein Foto.“

Ich hoffe sehr stark das war unterhaltsam gemeint!

Ansonsten hoffe ich daß du nie Elternteil 1 oder 2 wirst.

Dein Kind fände solche Fotos nämlich sehr unlustig.

Das war sarkastisch gemeint. Dem Kind ist das bis zu einem bestimmten alter egal. Da haben Kinder noch kein Schamgefühl.

Und weshalb hoffst du das nicht? Ich meine online Gespräche mit einem Arzt oder Apotheker kommen auch immer mehr.

Solange E1 und E2 das Bild nicht im Darknet verscherbelt haben und es dann in der Datenbank der Kinderpornoringe auftaucht und somit zu einem Treffer im Hash führt, ist das dem Algorithmus völlig egal ….

In einem anderen Forum habe ich gelesen das dieses mit Perceptual Hashes gemacht werden soll und dort durchaus Fehler geschehen. Ich bin da absolut technischer Laie und kann mich nur darauf verlassen was andere Schreiben.

Daran habe auch gedacht, wie kann der Algorithmus zwischen den ganzen Fotos unterscheiden? Ich bin mir sicher es werden einige Problem geben, wo es keine Verstöße gab!

Oder einfach zahlreiche Fotos aus dem Garten in welchem die Kinder spielen und im Pool planschen etc… ich habe also gleich mehrere hundert Fotos, welche alarmieren würden… und dann kommt der manuelle Scan eines mitsrbeiters… super

Wenn Du in ein Land reist, in dem entsprechende Gesetzte herrschen, dann landen alle Menschen aus freien Ländern im Knast, weil jeder dann irgendwas verbotenes auf dem Handy hat und Apple sich immer an lokale Gesetzte hält.

What happens on your iPhone, stays on your iPhone